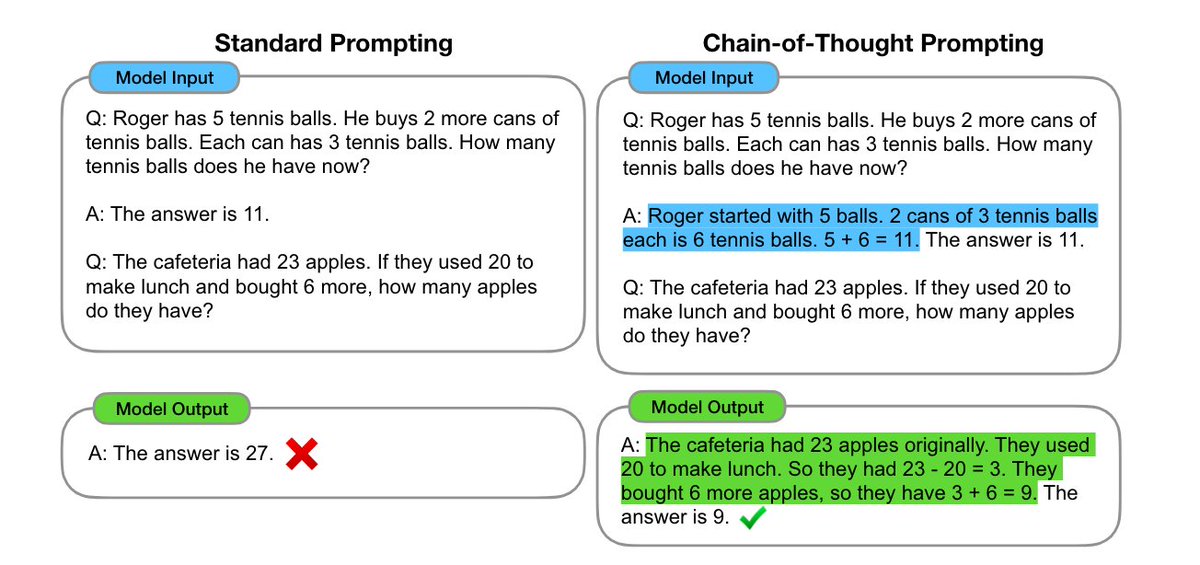

3/ 在CoT出现之前, LLM的发展遇到了尴尬的瓶颈,模型越来越大,处理文字能力越来越强,但却似乎没有涌现出接近人类的推理能力,包括算术(e.g. 8只鸡4只兔同笼,一共多少只脚),常识(e.g. 鸭梨能漂在水中么?)以及符号(e.g. 抛硬币若干次,到底哪面朝上)的推理。

5/ 这样以来,prompt的message形式由

<input, output>

转化为:

<input, chain of thought, output>

<input, output>

转化为:

<input, chain of thought, output>

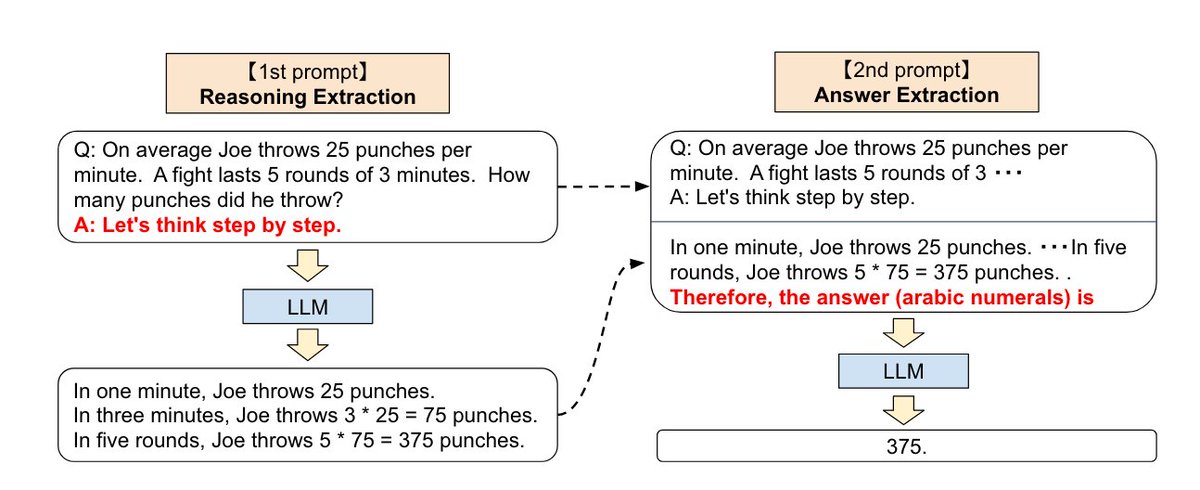

6/ 之前的thread讲过language modeling,而CoT的思想与之呼应。当chain of thought被放在prompt中时,就会强制LLM在给出答案前, 把chain of thought输出。

从条件概率分布的角度来讲,答案在chain of thought后,其准确的可能性更大。

这也反应了一个问题,即LLM或许没有思考,它只在乎输出。

从条件概率分布的角度来讲,答案在chain of thought后,其准确的可能性更大。

这也反应了一个问题,即LLM或许没有思考,它只在乎输出。

7/ 作者经过实验,发现这种简单的prompting方式在超过1000亿的大模型上非常有效,而在小模型上效果不明显。

如果将‘涌现’定义为:

“由量变引起的质变”

那么虽然作者没有直接证明大模型可以推理,但直接证明了经过CoT, 大模型的推理能力可以被解锁,并且这种能力在超过1000亿的超大模型上得以涌现。

如果将‘涌现’定义为:

“由量变引起的质变”

那么虽然作者没有直接证明大模型可以推理,但直接证明了经过CoT, 大模型的推理能力可以被解锁,并且这种能力在超过1000亿的超大模型上得以涌现。

8/ 题外话,ChatGPT一种涌现的工具,其强大的涌现能力与作者Jason有直接的联系,我们有理由怀疑,不开源的ChatGPT下,或针对用户的输入和任务,有着隐含的CoT,来引导大模型获得更加突出的表现。

11/ 下面给出一个在@LangChainAI 中使用 chain-of-thought 来完成SQL query generation的例子

arxiv.org/abs/2205.11916

Large Language Models are Zero-Shot Reasoners

Pretrained large language models (LLMs) are widely used in many sub-fields of natural language proce...

arxiv.org/abs/2201.11903

Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

We explore how generating a chain of thought -- a series of intermediate reasoning steps -- signific...

13/ 下一个thread,将记录用CoT完成api和工具使用的paper读书笔记,如果你喜欢我的读书笔记,请关注我 @realrenmin ,每周会写一到两个长thread跟大家分享NLP的知识。

Loading suggestions...