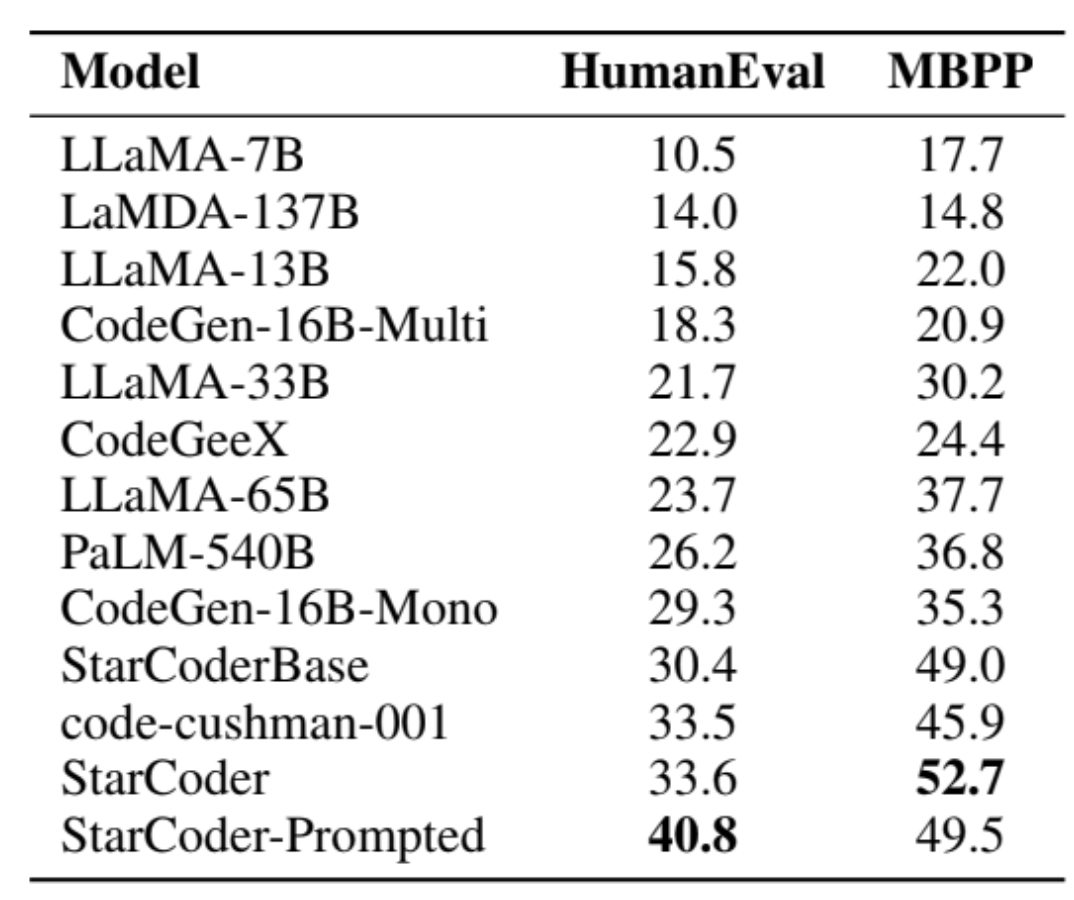

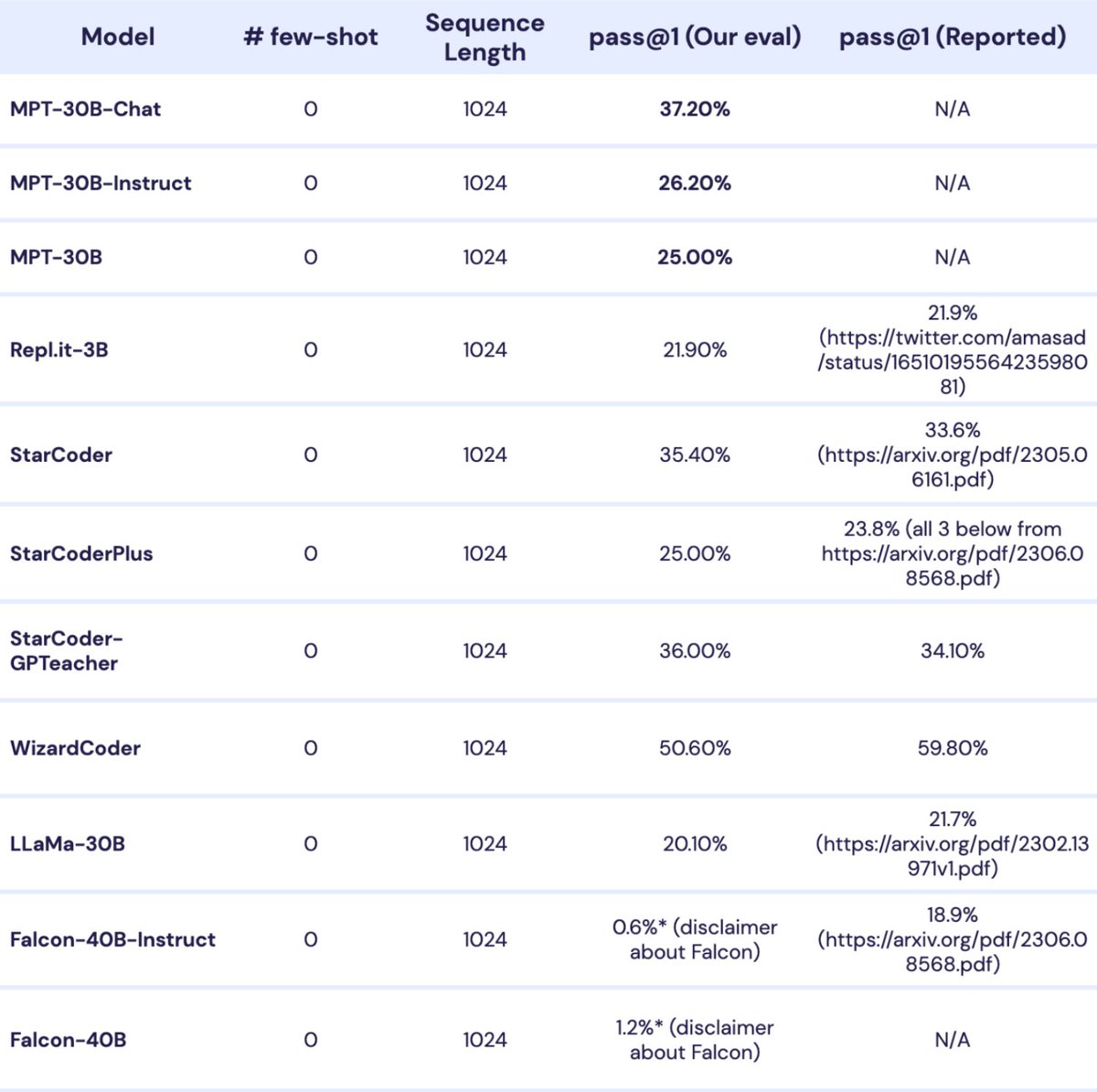

1️⃣ StarCoder

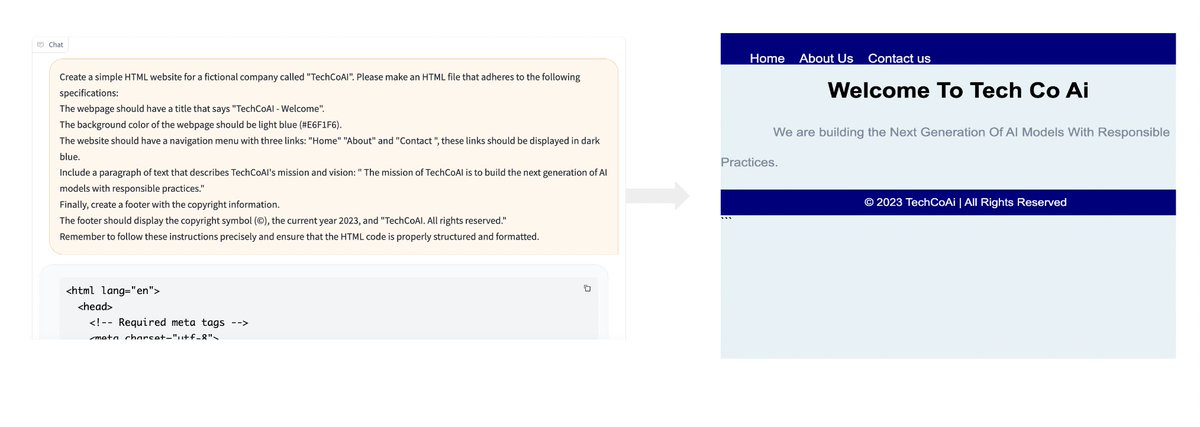

• 源自GPT2模型的AI编程神器,通过训练各种GitHub代码集。

• 15B的参数 + 8K的上下文

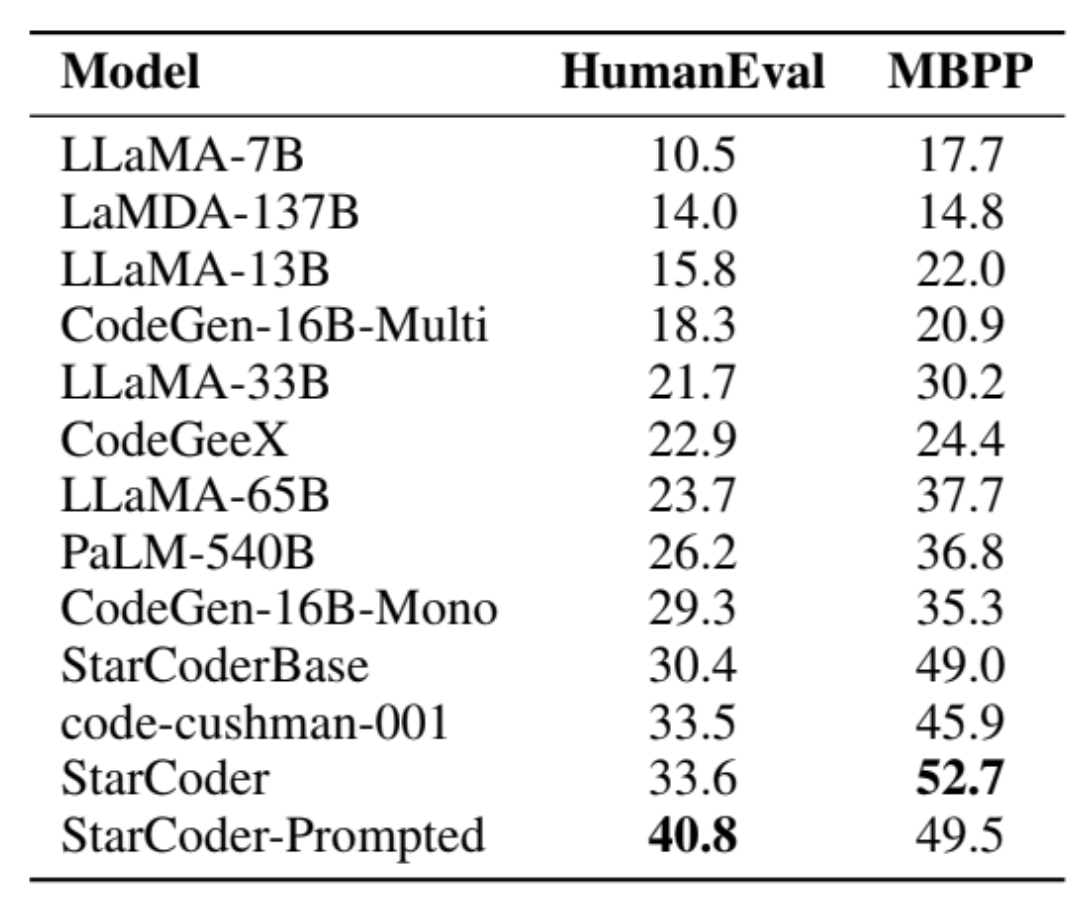

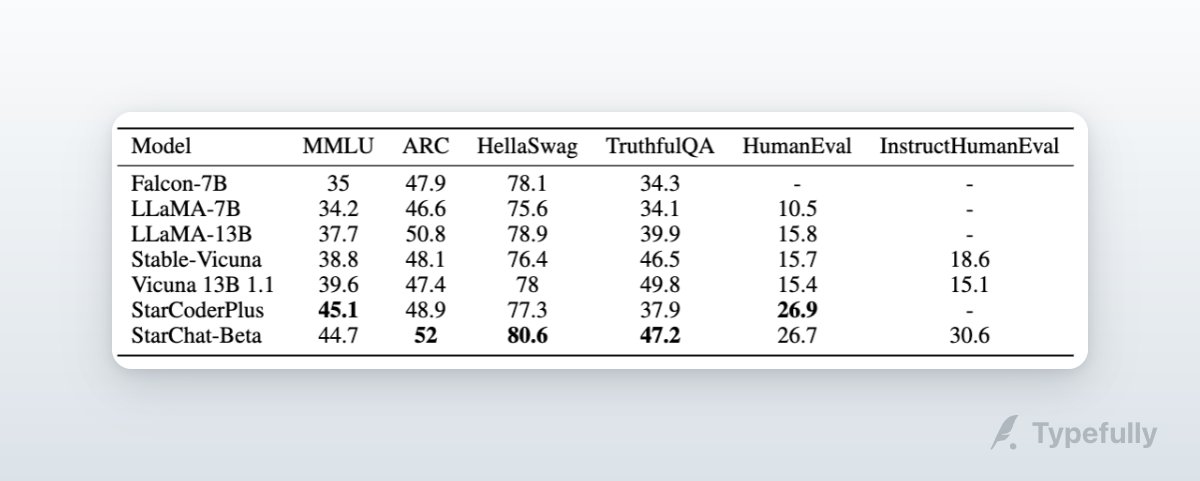

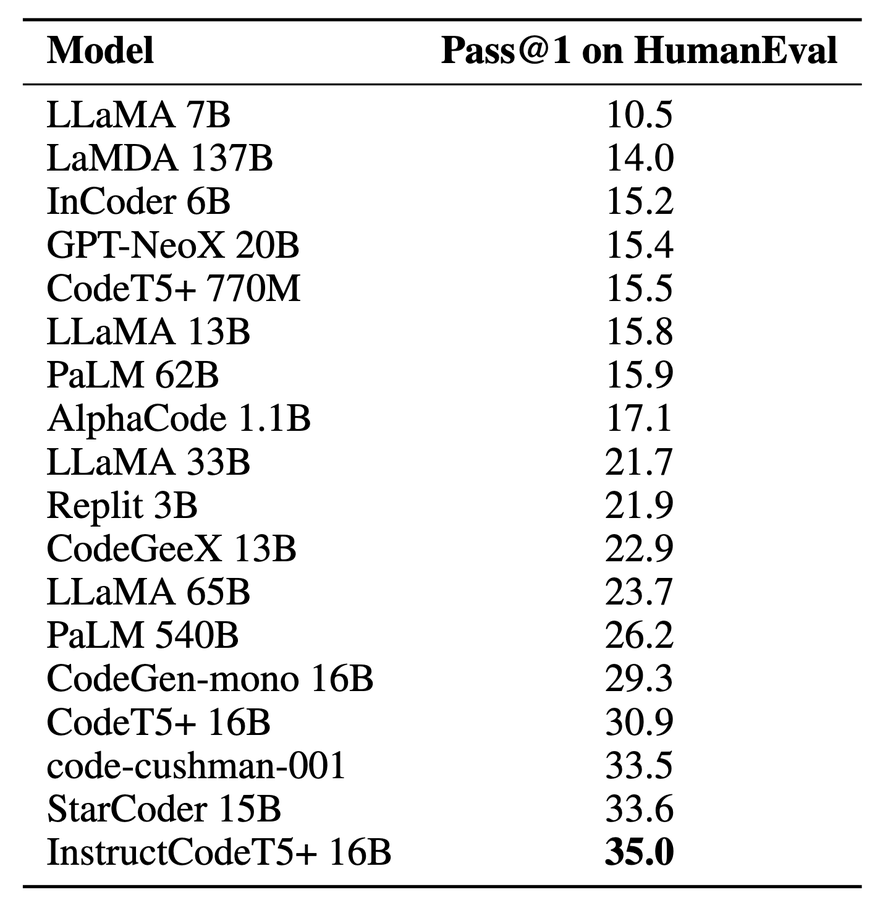

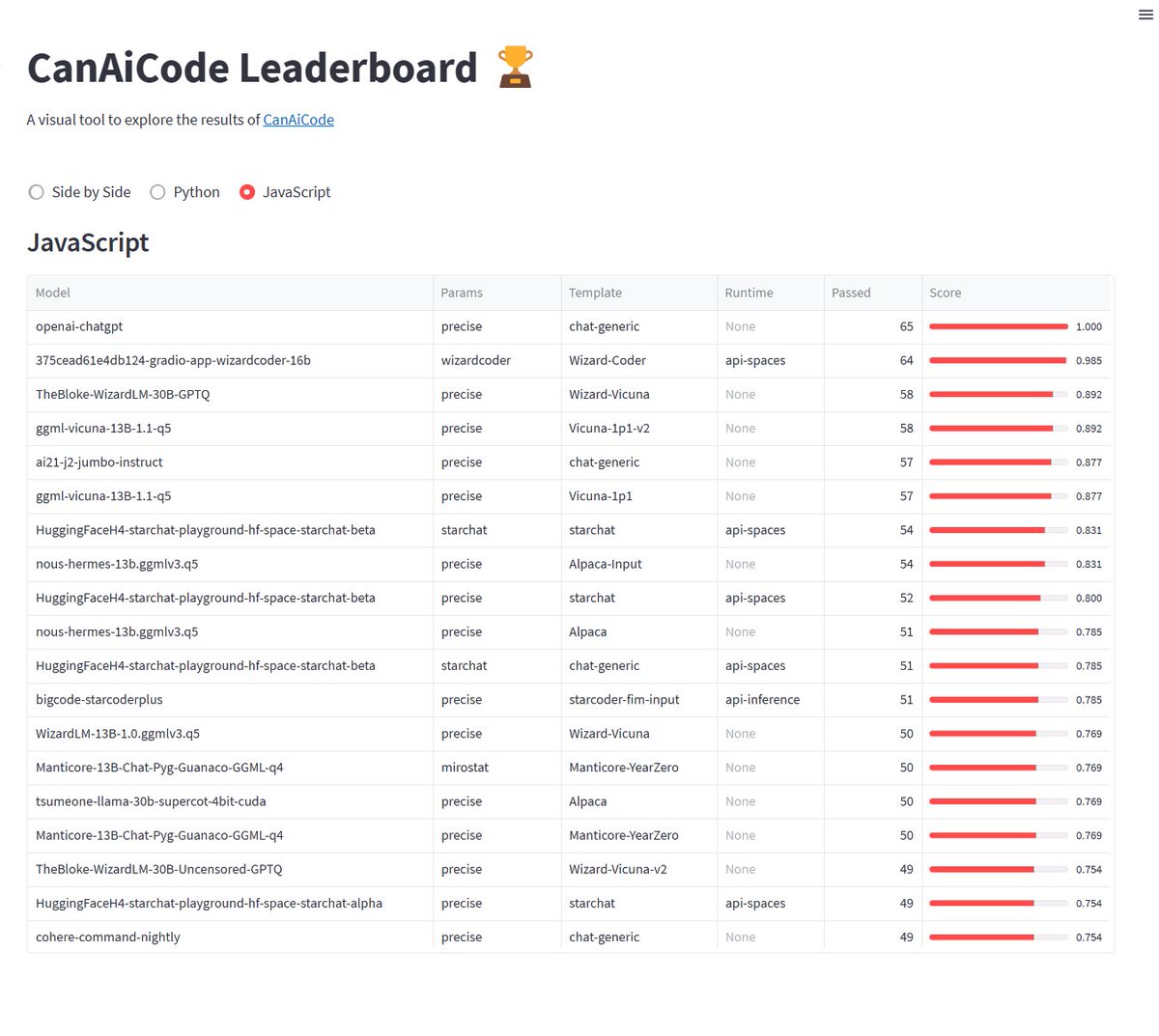

• 在80多种编程语言中磨炼,StarCoder拥有强大的代码补全和错误修复能力。在HumanEval评估中,竟可达到40%的pass@1得分,将成为你的编码好助手!

• 推特:

• 源自GPT2模型的AI编程神器,通过训练各种GitHub代码集。

• 15B的参数 + 8K的上下文

• 在80多种编程语言中磨炼,StarCoder拥有强大的代码补全和错误修复能力。在HumanEval评估中,竟可达到40%的pass@1得分,将成为你的编码好助手!

• 推特:

4️⃣ LTM

• LTM,一款具有长期记忆网络(Long-term Memory Network)技术的LLM,可以支持最大500万Tokens,让你的代码库得以完整呈现,如同编写长篇小说一般轻松自如。

• 此模型能够支持巨大的上下文窗口,以至于可以完全覆盖大部分代码库。

• 推特:

• LTM,一款具有长期记忆网络(Long-term Memory Network)技术的LLM,可以支持最大500万Tokens,让你的代码库得以完整呈现,如同编写长篇小说一般轻松自如。

• 此模型能够支持巨大的上下文窗口,以至于可以完全覆盖大部分代码库。

• 推特:

5️⃣ DIDACT

• 由Google研发,是第一个被训练用来模拟真实软件开发者编写代码、修复构建、并进行代码审查的LLM。能够逐步构建软件基于开发者的工作历史。

• 可以帮助开发者修复构建错误,预测代码审查意见,甚至像GitHub Copilot一样,根据你的开发历史来完成代码补全。

• 由Google研发,是第一个被训练用来模拟真实软件开发者编写代码、修复构建、并进行代码审查的LLM。能够逐步构建软件基于开发者的工作历史。

• 可以帮助开发者修复构建错误,预测代码审查意见,甚至像GitHub Copilot一样,根据你的开发历史来完成代码补全。

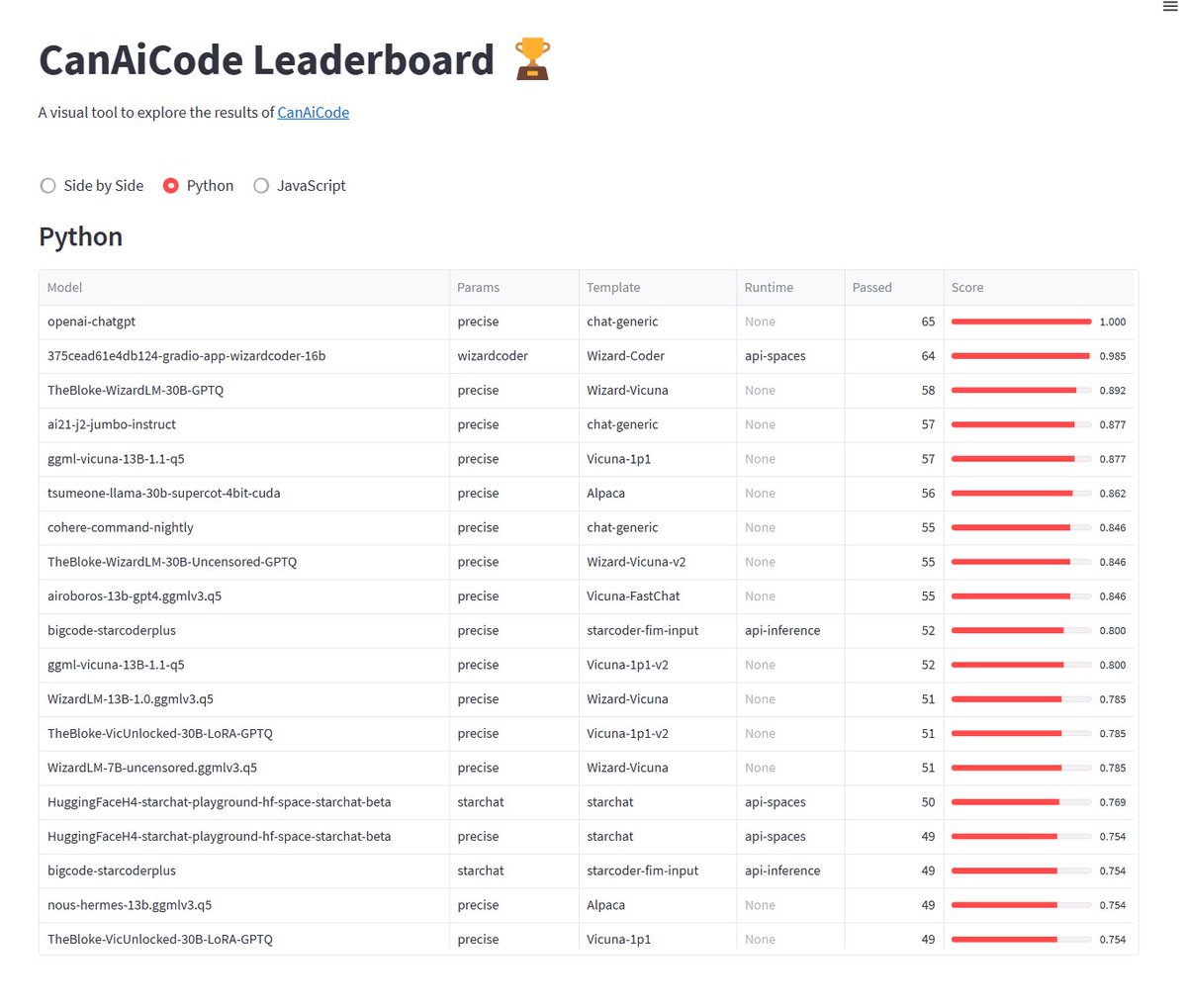

6️⃣ WizardCoder

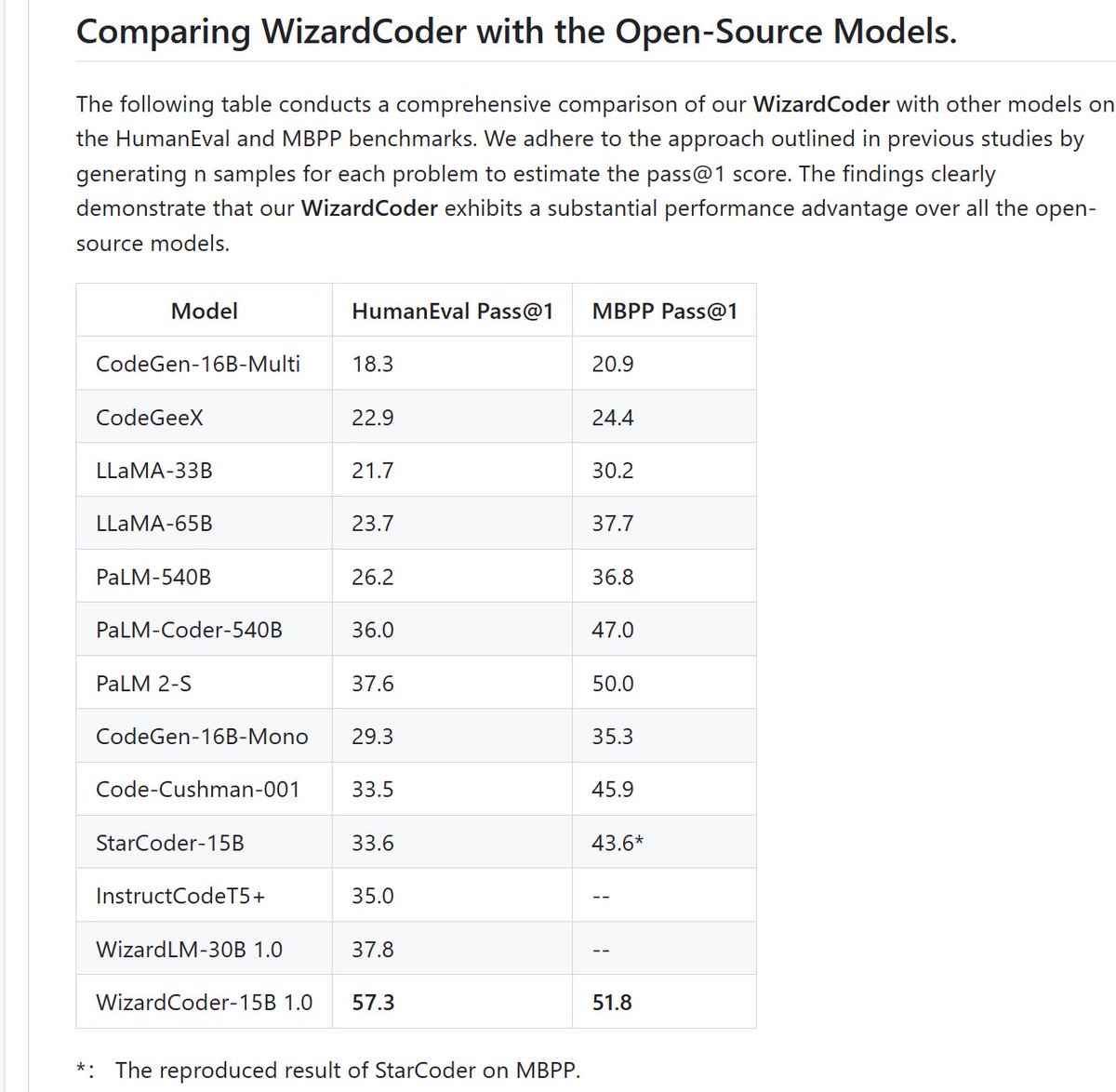

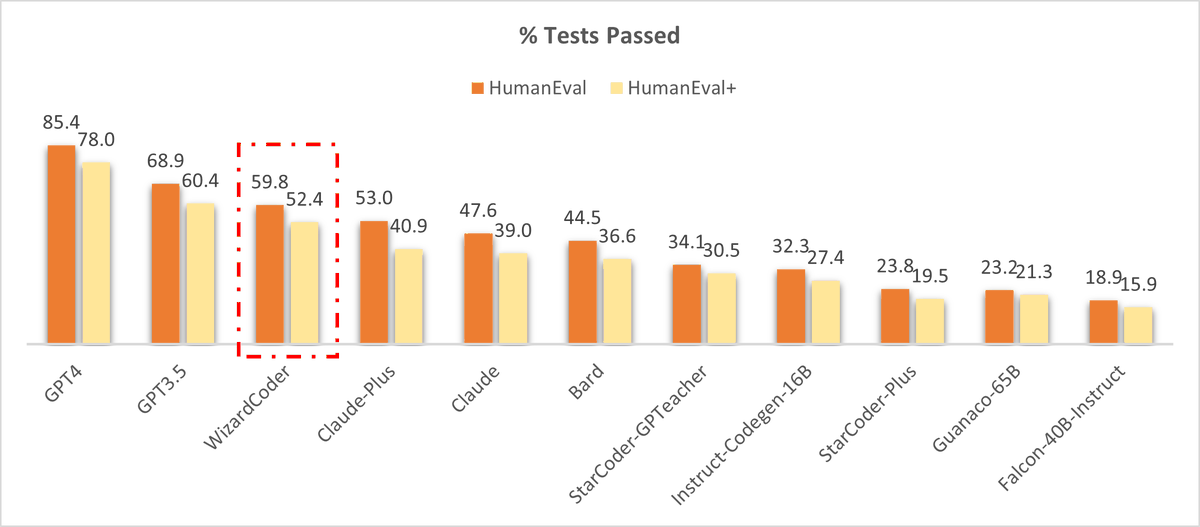

• WizardCoder,这是一款全新的开源代码LLM。通过应用Evol-Instruct方法(类似orca),它在复杂的指令微调中展现出强大的力量,得分甚至超越了所有的开源Code LLM,及Claude、Bard等闭源LLM,达到了惊人的57.3的HumanEval pass@1得分。

• 推特:

• WizardCoder,这是一款全新的开源代码LLM。通过应用Evol-Instruct方法(类似orca),它在复杂的指令微调中展现出强大的力量,得分甚至超越了所有的开源Code LLM,及Claude、Bard等闭源LLM,达到了惊人的57.3的HumanEval pass@1得分。

• 推特:

7️⃣ FalCoder-7B

• FalCoder-7B,源于Falcon模型,经过CodeAlpaca20k数据集的细微调整,,专为代码指令补全而生。因为Falcon的质量不错,且可商用,基于这个的coder model可以供参考

• 推特:

• FalCoder-7B,源于Falcon模型,经过CodeAlpaca20k数据集的细微调整,,专为代码指令补全而生。因为Falcon的质量不错,且可商用,基于这个的coder model可以供参考

• 推特:

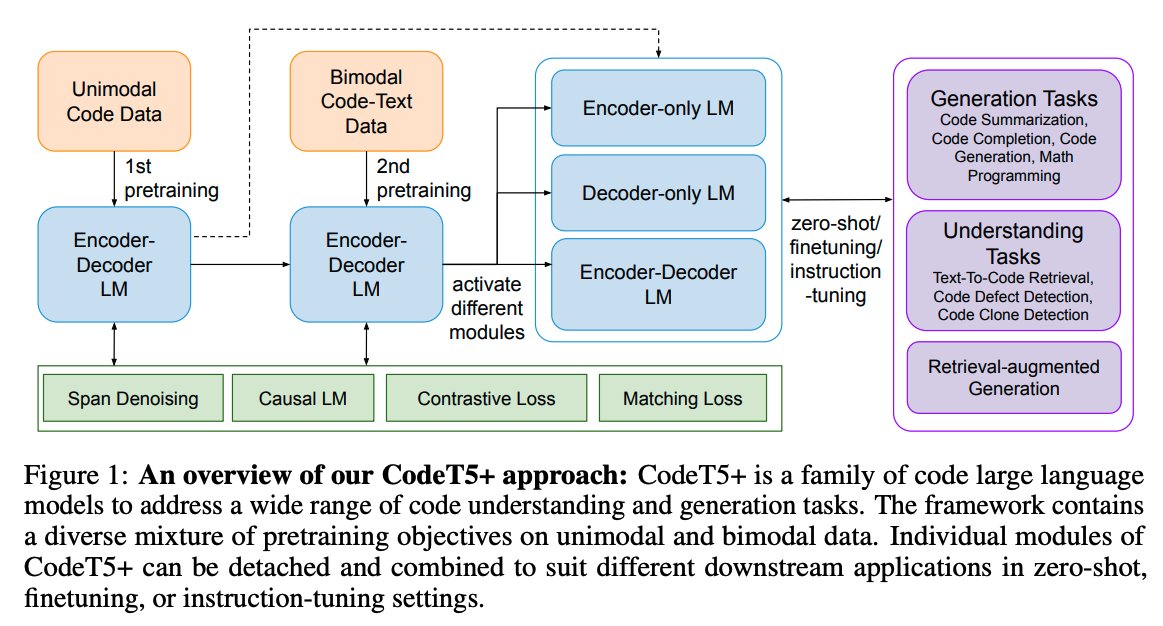

arxiv.org/abs/2305.06161

StarCoder: may the source be with you!

The BigCode community, an open-scientific collaboration working on the responsible development of La...

huggingface.co/bigcode/starco…

bigcode/starcoderbase · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open s...

huggingface.co/blog/starcoder

StarCoder: A State-of-the-Art LLM for Code

We’re on a journey to advance and democratize artificial intelligence through open source and open s...

huggingface.co/HuggingFaceH4/…

HuggingFaceH4/starchat-beta · Hugging Face

We’re on a journey to advance and democratize artificial intelligence through open source and open s...

huggingface.co/spaces/Hugging…

Open LLM Leaderboard - a Hugging Face Space by HuggingFaceH4

Discover amazing ML apps made by the community

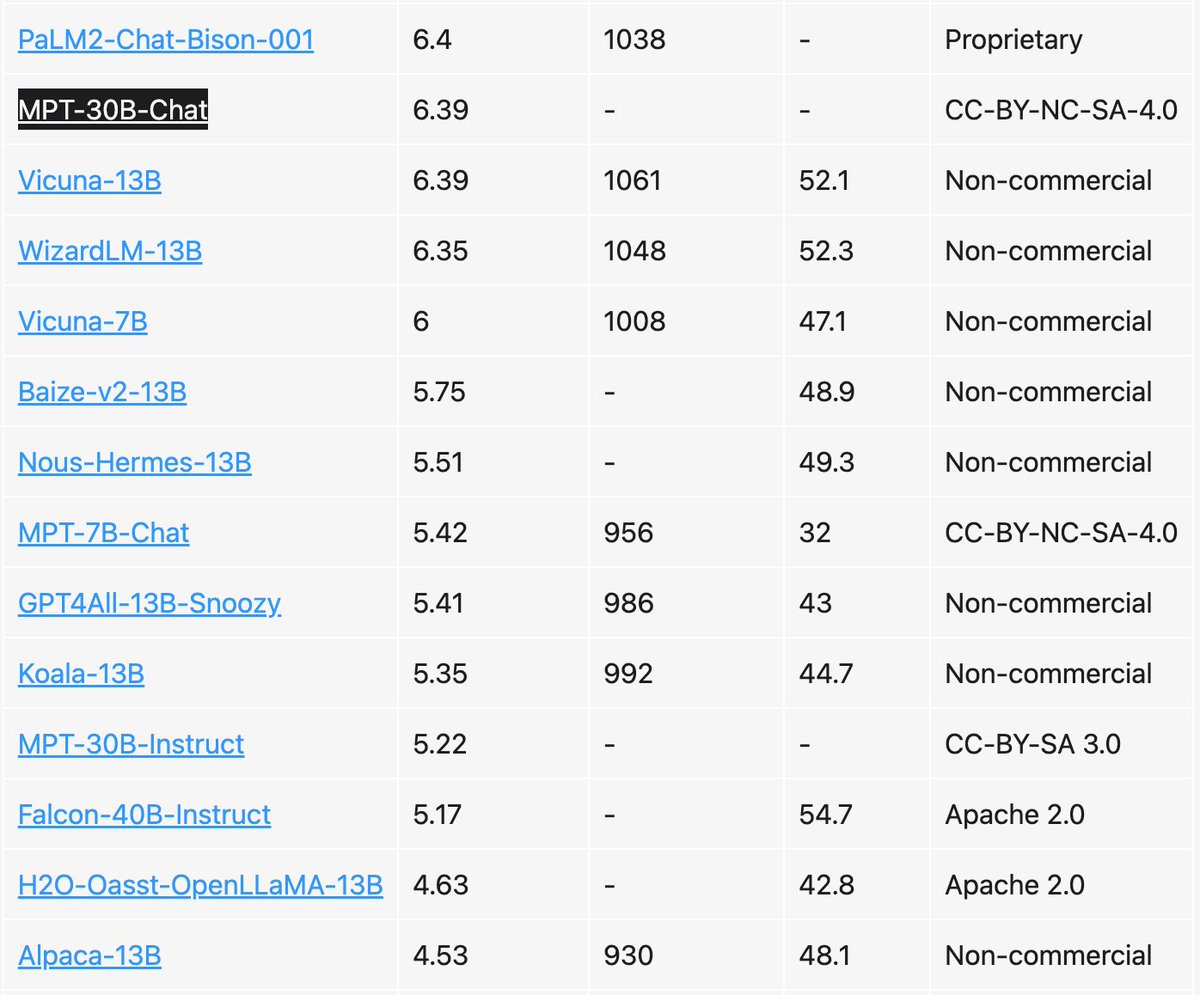

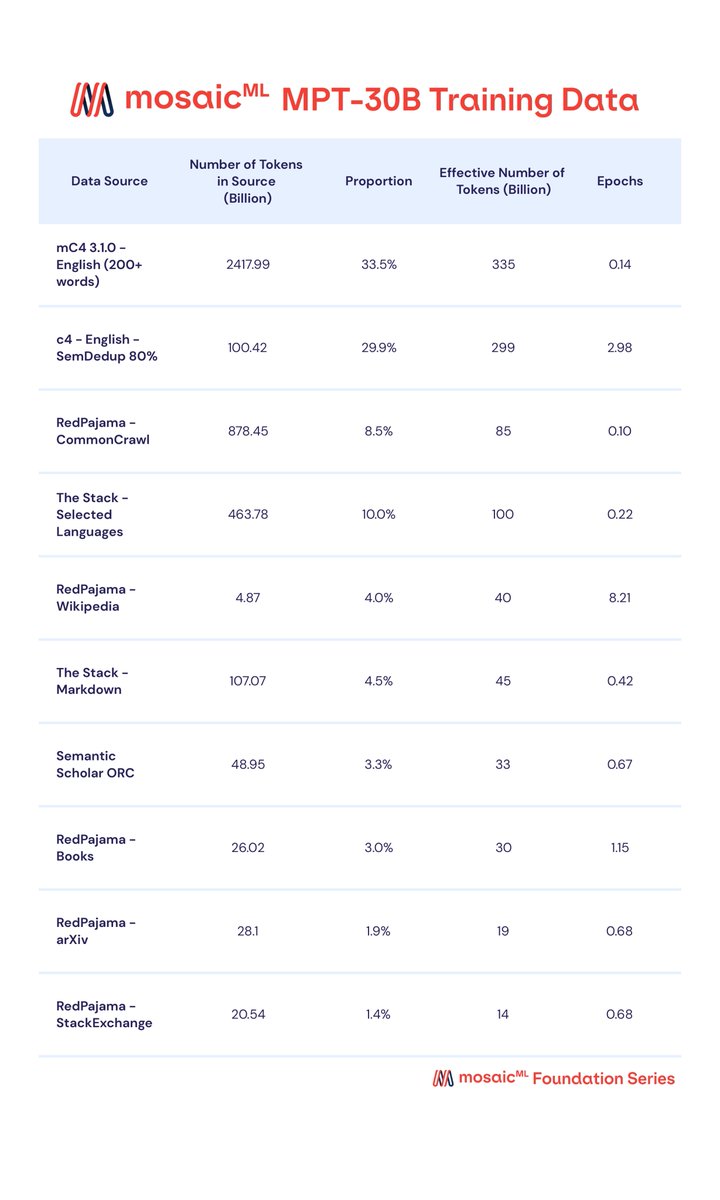

• 拥有一些独特的特性,例如能够通过ALiBi扩展上下文长度,通过FlashAttention进行高效推理和训练,还可以方便地部署在单个GPU上。

• Youtube介绍视频:youtu.be

• Huggingface demo:huggingface.co

• Youtube介绍视频:youtu.be

• Huggingface demo:huggingface.co

Loading suggestions...